一名程序员眼中的 AI 故事

2025 年初,一家来自中国杭州的公司推出了其自研的推理语言模型 DeepSeek-R1,并上线至自家网站和 APP 中。

他们不仅以相对较低的成本实现了不逊于世界顶尖 AI 模型的效果,还选择开源模型参数、公开实现细节,使得其他公司和机构也可以直接部署应用、跟进研究。

一时间,DeepSeek 成为了全球科技圈的焦点话题。

新闻资讯中,国产自研、开源免费、深度思考等关键词频繁闪烁,吸引着民众的目光。

但它带来的影响力远不止于此,更重要的是,它打破了前沿科技成果与普罗大众之间的壁垒。

任何人,无论身处世界哪个角落,都可以轻松登录网站或下载 APP,便捷体验到这一最新科技成果,前沿 AI 不再是专业人员的专属,也无需受到”墙“的限制。

这一举动,如同春风化雨,滋润着每一个对科技抱有好奇之心的人,也使得 AI 再度成为了大街小巷、线上线下热议的话题,引发全民对人工智能的新一轮思考与探讨。

或许你打开招聘软件时,也曾被 AI 领域提供的高薪岗位所吸引,想知道要学什么才能干这一行?

或许你身边有一些朋友,正从事那些听起来高大上的 AI 算法工程师、算法研究员的工作,好奇他们到底在做什么?

AI 究竟是什么,AI 领域在做哪些事情?

希望本文能为你带来一些答案。

维基百科上对 AI 的解释是这样的:

人工智能(AI)是指计算系统执行与通常人类智慧相关的任务的能力,比如学习、推理、解题、感知和决策。

Artificial intelligence (AI) refers to the capability of computational systems to perform tasks typically associated with human intelligence, such as learning, reasoning, problem-solving, perception, and decision-making.

这个定义并不具体,但从中能捕捉到一个关键词——human intelligence(人类智慧/智能)。

可以说,计算机这一伟大产物的发明,本身就源自科学家们对智能的追求:希望制造出可以代替人类进行计算的机器。

事实上,任何人类计算过程,本质上都可拆解为有限步骤的指令序列。

从图灵机的理论构想,到冯·诺依曼架构的物理实现,计算机的诞生,意味着人类可以通过编写指令、设计规则,让机器严格遵循执行、完成相应工作。

由此又衍生出了许多方向:设计各式各样的编程语言、开发便利的软件用于生产或服务、通过网络连接四海、制作游戏与动画为大众提供娱乐…

这些方向的发展固然极大改善了我们的生活,但我们仍会觉得,这些所谓的机器/程序,都只是在程序员预先设计的规则范围内工作,凭借着精准强大的计算能力完成工作,并没有真正达到媲美人类的智力水平。

自始至终,科学家们有一种终极追求——希望创造出与人类同等聪明、甚至更加聪明的机器,它们能够替代人类工作、甚至完成那些普通人类难以做好的任务。

一切对 AI 的研究探索,本质上都是以此为目的。

也因此发展出了对于 AI 的两种视角:

- AI 是一种智能体(Intelligence Agent),能够

- 像人一样思考,记忆、学习、推理…

- 像人一样行动,感知、交流、执行动作…

- AI 是一类工具(AI Tools),希望

- 尝试解决人类做不好的问题,计划、调度、建模、预测…

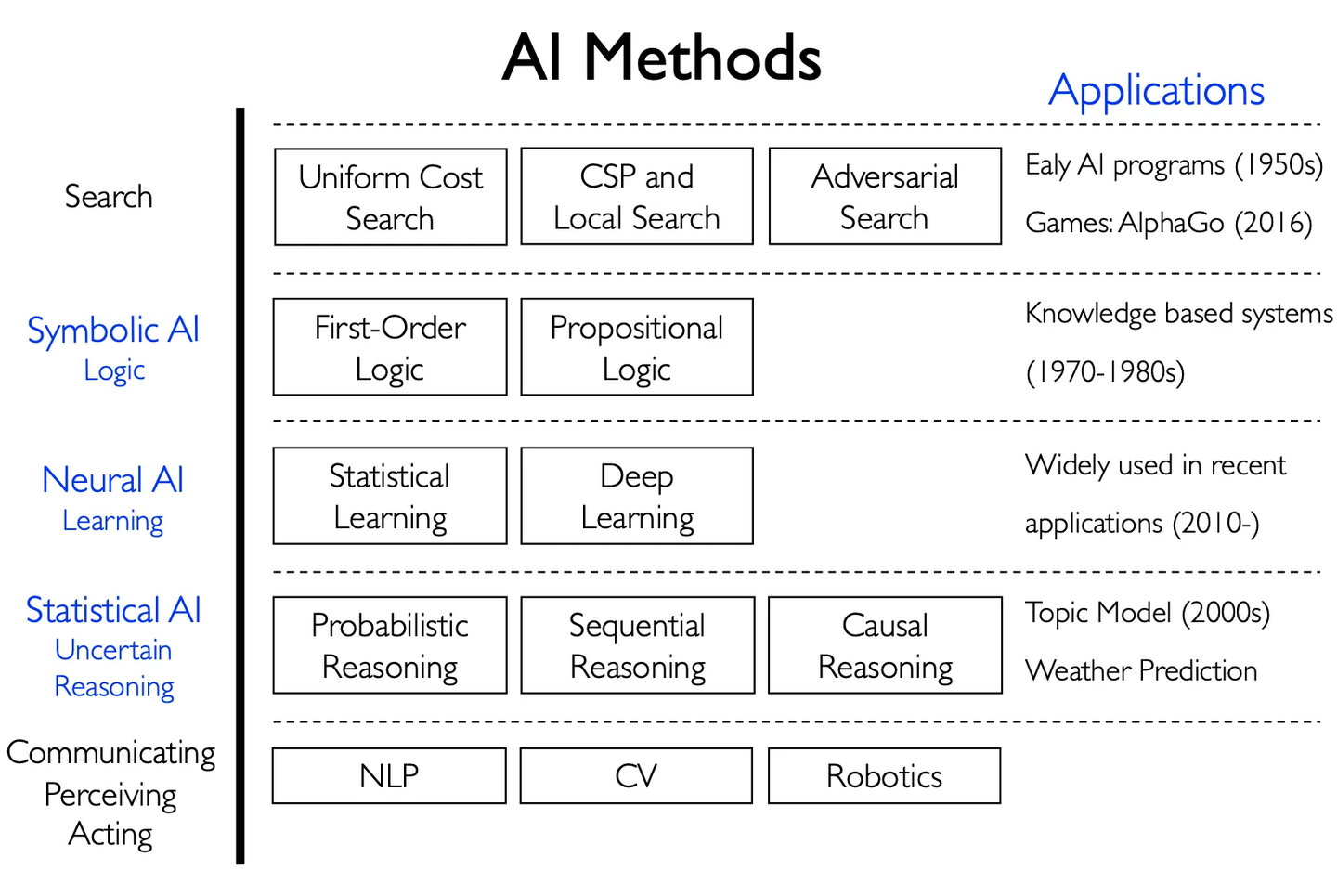

为了解决这些问题,科学家们陆陆续续提出各种思路:

1. 基于搜索的方法

核心思想:在求解问题时,通过系统性地枚举和评估可能解来寻找答案。

早期 AI 的思路很简单,就是尝试不同的组合,直到找到解为止。

通过这种方式,可以让机器掌握简单的棋类游戏、完成一些基本定理的证明以及在有限领域实现问题的求解。

可惜,也就仅此而已了。

问题主要出在两个方面:

其一,此类方法是基于人类如何执行任务来进行 AI 的设计,而不是让 AI 自主基于对任务的分析理解来产生答案。也就是说,需要人为进行问题拆解,给出的明确的状态空间和目标定义。

其二,早期实验的任务往往较为简单,当扩展的更大的问题时,计算的复杂度往往极高,远远超出了机器通过”暴力“方法能够求解的范围。比如围棋的局面总数是(约

),即使每秒计算万亿次,单纯遍历一遍所有可能棋局所需的时间也超过了宇宙的年龄。纯粹依靠计算,能力终究是有上限的。

种种问题最终导致了第一次 AI 寒冬的降临,AI 发展陷入了阶段性的困境。

2. 基于符号主义的 AI

核心思想:用逻辑规则和符号表示知识,依赖人工构建知识库来完善推理过程——专家系统。

对于使用搜索方法进行问题求解时存在的不足,一种应对方案是采用更强大的领域特定知识,因此允许更大规模的推理步骤,也可以更轻松地处理特定专业领域中发生的典型案例。

就好像求解一道高难度数学题,需要预先知道足够多的复杂二级结论,才能顺利攻克——必须要差不多知道答案才能解决一个难题。

顺着这个方向发展,诞生了一些实用的专家系统,包括能从质谱仪提供的信息推断分子结构的 Dendral 系统、用于诊断血液感染的 Mycin 系统。

然而,为复杂领域构建和维护专家系统过于困难,并且系统使用的推理方法往往无法应对不确定性,也难以从经验中学习。

这些看似复杂的系统,甚至连现实中简单的字母识别、图片分类问题都无法很好地解决。

这些难题使得 AI 发展再次受阻,进而引发了第二次 AI 寒冬。

3. 基于连接主义的 AI

核心思想:仿照大脑神经元结构构建神经网络,从样本中学习——深度学习。

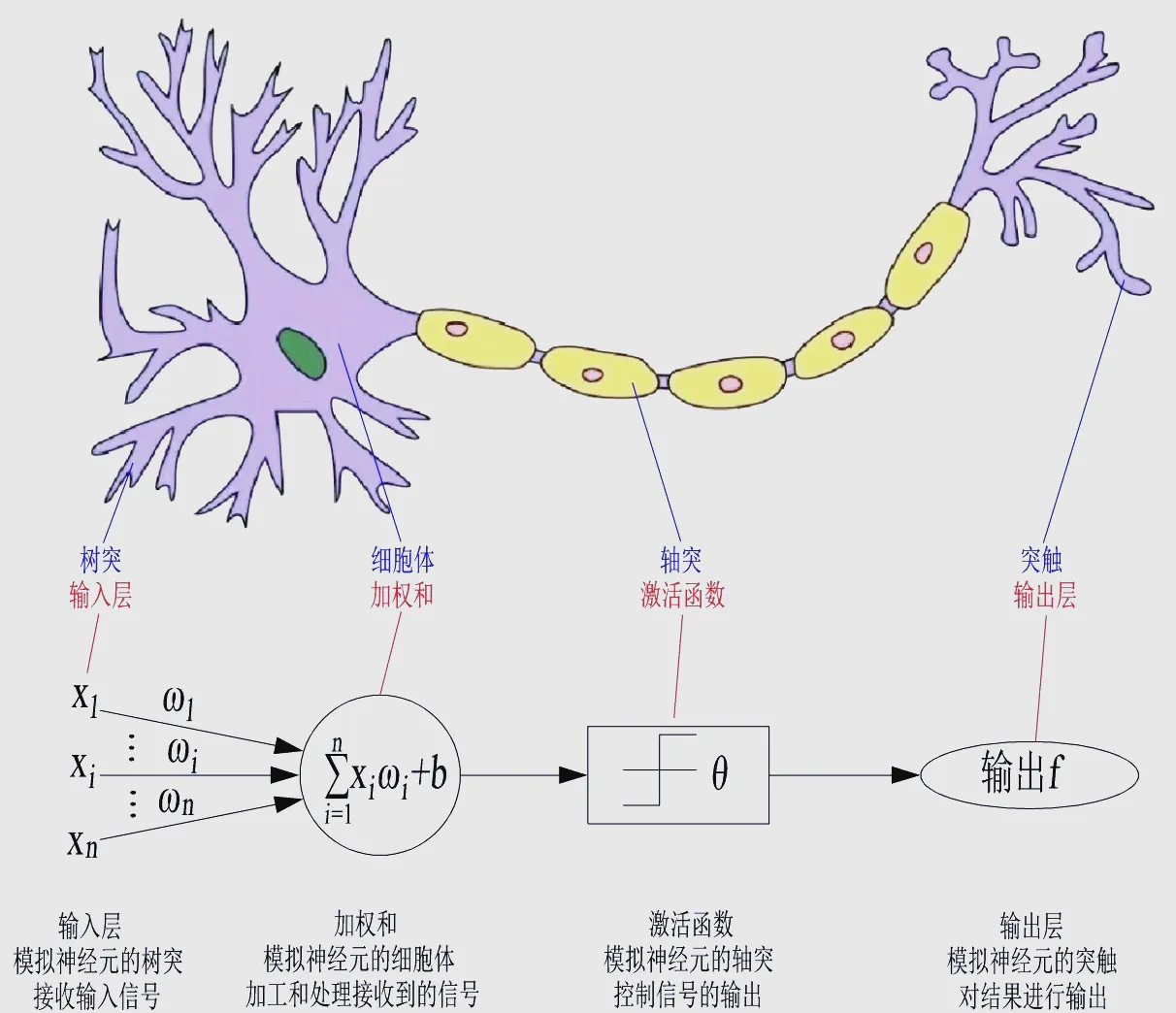

连接主义的思路来自基础生理学知识,将大脑神经元抽象为具有输入和输出的逻辑单元:

接收一组输入信号,每个输入信号带有不同的权重,通过累加权重计算出总和,如果总和超过设定的阈值,神经元就被”激活“产生输出信号。

输出信号又能作为其他神经元的输入,如此便可形成复杂的神经网络。

事实上,在人工智能发展初期,就诞生了使用感知机(Perceptron)模型来模拟神经元的 Mark 1,能够进行”错误驱动“的学习,根据样本调整权重、更新模型,从而能在识别字母的任务中解决相当复杂的问题。

尽管感知机模型一度被寄予厚望,被证明可以学习它们能够表示的任何事物,但无奈其表示能力有限(因为只有一层)。

有人指出,其甚至在面对简单的 “异或” 逻辑问题时也束手无策,这无疑给连接主义泼了一盆冷水,造成了人工神经领域发展的长年停滞及低潮。

直到多年后,人们认识到通过激活函数连接的多层感知机(MLP,Multilayer Perceptron)没有单层感知机固有的缺陷,反向传播算法也被重新发明(早期未能引起重视),人工神经领域的研究才有所恢复。

在大数据时代,神经网络的潜力终于得到了充分的释放。得益于计算能力的提升、海量数据的积累以及算法的持续创新,深度学习——即使用更多层、更复杂结构的神经网络,在图像识别(CNN,Convolutional Neural Network)、自然语言处理(Transformer)、推荐系统(Wide&Deep)等诸多领域取得了巨大突破,被广泛应用于人们生活之中。

不过,这种基于连接主义的 AI 也并非十全十美,其最大的 “硬伤” 在于模型运行过程不再具有直观的可解释性,如同一个神秘的黑箱,输入数据后直接输出结果,中间的运算机制难以窥探。

4. 基于概率推理的 AI

核心思想:用概率模型量化不确定性,实现可解释的统计推理与决策——统计学习。

为了避免专家系统的脆弱性,经历寒冬后的科学家们希望基于现有理论,通过一种结合概率、基于机器学习、重视实验结果的方法,对现实问题进行更科学有效的建模。

数学(主要是概率论与统计学)的严谨与优雅终于开始在人工智能领域大放异彩。

在语音识别中引入隐马尔可夫模型(HMM,Hidden Markov Model),基于严格的数学理论、在大量真实语音数据上训练,大幅提升了识别准确率。

贝叶斯网络的发展演进,也产生了一种用于表示不确定知识的严格而有效的体系,被广泛应用到生物学、医学、信息检索等领域。

相较于神经网络依赖海量数据且内部黑盒的特点,基于概率推理的 AI 能够靠先验知识实现小样本下的学习,并且对因果关系进行显式建模,具有较强的可解释性。

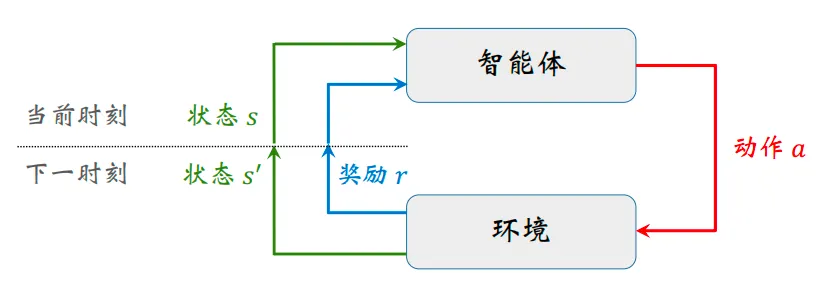

5. 基于行为主义的 AI

核心思想:智能体通过与环境交互(试错+奖励机制)优化策略——强化学习。

有一派科学家并不执着于探究大脑内部具体的工作机制,而是相信机器经过足够的实践之后自然会孕育出智慧。

具体而言,就是让机器在实际环境中直接感知和行动,随后依据环境给予的反馈及时调整策略,如此循环往复,更好地适应环境变化,或朝着预设目标稳步迈进。

这种理念在游戏 AI、机器人控制、自动驾驶等领域找到了用武之地,比如在复杂度极高的围棋比赛中击败人类顶级选手的 AlphaGo,便是强化学习与深度学习结合应用的结果。

6. 针对人类智能的细分能力,也分别发展出了专门技术

- 感知(计算机视觉,CV):让机器"看懂"世界(如人脸识别、目标检测)。

- 交流(自然语言处理,NLP):让机器理解并生成语言(如机器翻译、ChatGPT/DeepSeek)。

- 执行(机器人学,Robotics):将决策转化为物理动作(如工业机械臂控制)。

事实上,上述的每种方法都有其优势和局限,现代 AI 往往采用混合架构,各类方法的界限正变得越来越模糊。这种交叉融合的趋势在多个领域都有鲜明体现:

- ChatGPT:将 Transformer 架构的神经网络(连接主义)与人类反馈强化学习(行为主义)相结合

- AlphaFold:结合了深度学习(连接主义)与生物物理规则(符号主义),成功预测蛋白质 3D 结构

- 自动驾驶系统:融合了计算机视觉(感知)、机器人控制(执行)和强化学习(决策)

这种多范式融合不仅弥补了单一方法的局限性,更是推动着 AI 向更通用、更强大的方向发展,为实现真正的通用人工智能(AGI)铺平道路。

在过去的几年里,AI 技术以惊人的速度发展,从实验室走向产业应用,创造了大量新兴发展方向和职业机会:

搜索、广告、推荐系统为企业带来巨大流量和收益,风控系统保障着金融交易安全,人脸识别技术已广泛应用于安防和支付领域,大型语言模型(LLM)正重塑人机交互方式,AI 绘画将改变原有的艺术创作方式,自动驾驶技术也在如火如荼地推进商业化落地…

市场上 AI 相关岗位层出不穷,岗位名称也五花八门,但对于 AI 技术研发,本质上可以划分为以下几大核心类别:

- 算法工程师(Machine Learning Engineer):负责将已有算法落地到实际业务场景(推荐/风控/CV/NLP等)。除了对算法/模型本身的熟悉,工程能力与对特定领域(如推荐系统)的业务理解同样将在工作中发挥重要作用。

- 算法研究员(Research Scientist):进行前沿算法探索(如 LLM 架构创新),相当于做的是科学家的工作,只是就职于商业公司而非纯研究机构。此类岗位对知识和逻辑能力的要求极高,往往需要博士才能胜任。

- 当下,AI 领域最前沿的突破往往诞生于头部科技公司,甚至可能对公司发展、行业未来造成颠覆性影响,因此各大公司对该岗位的重视程度也越来越高。

- AI Infra 工程师(AI Infrastructure Engineer):核心职责是构建训练/推理基础设施,为算法落地提供基座支持,因此往往需要同时了解算法原理和底层系统实现。

- 随着 AI 模型规模不断扩大(如 GPT-4、Sora 等),更高效地进行训练与推理变得愈发重要,Infra 工程师的重要性便日益凸显。DeepSeek 能用较低的成本训练出全球顶尖的模型,很大程度上便是他们那些 Infra 工程师的功劳。

不过,难度大、前沿高端的技术并不能代表一切。

AI 应用的开发,尽管只是将 AI 能力整合到各类应用中,但除了对于传统前后端技术栈的掌握,同样需要对 AI 有着足够的认知。

如 Perplexity(AI 搜索)、Cursor(AI 编程)此类在全球范围高速发展的 AI 应用,并未实现底层模型技术的突破,而是聚焦于AI 应用,用前沿技术来切实解决用户的痛点。

“你对事情的理解,就是你在这件事情上的竞争力。因为理论上其他生产要素都可以构建。你对这件事情的认知越深刻你就越有竞争力。”——张一鸣

互联网上流传着英国科幻作家道格拉斯·亚当斯提出的科技三定律:

一、任何在我出生时已经有的科技都是稀松平常的世界本来秩序的一部分。

二、任何在我 15-35 岁之间诞生的科技都是将会改变世界的革命性产物。

三、任何在我 35 岁之后诞生的科技都是违反自然规律要遭天谴的。

如今二十出头的我,仍然有很多很多的想法与渴望:想拥有智慧和财富,想去尝试和拼搏,渴望不断拥抱变化而非循规蹈矩…

新一代 AI 技术带来的改变正在发生:

AI 创作的文案、画作已充斥互联网的各个角落;

AI 编写的代码正运行于许多复杂的软件系统;

AI 驾驶的车辆开始行驶在世界各地的马路上。

或许我们这代人的职业生涯也会因此发生深刻的改变。

但我也始终相信一点:无论 AI 再怎么发展,当我想表达点什么的时候,它终究无法代劳。

查看4道真题和解析

查看4道真题和解析