hiveOnSpark运行出现错误,如何解决呢?急急急急急

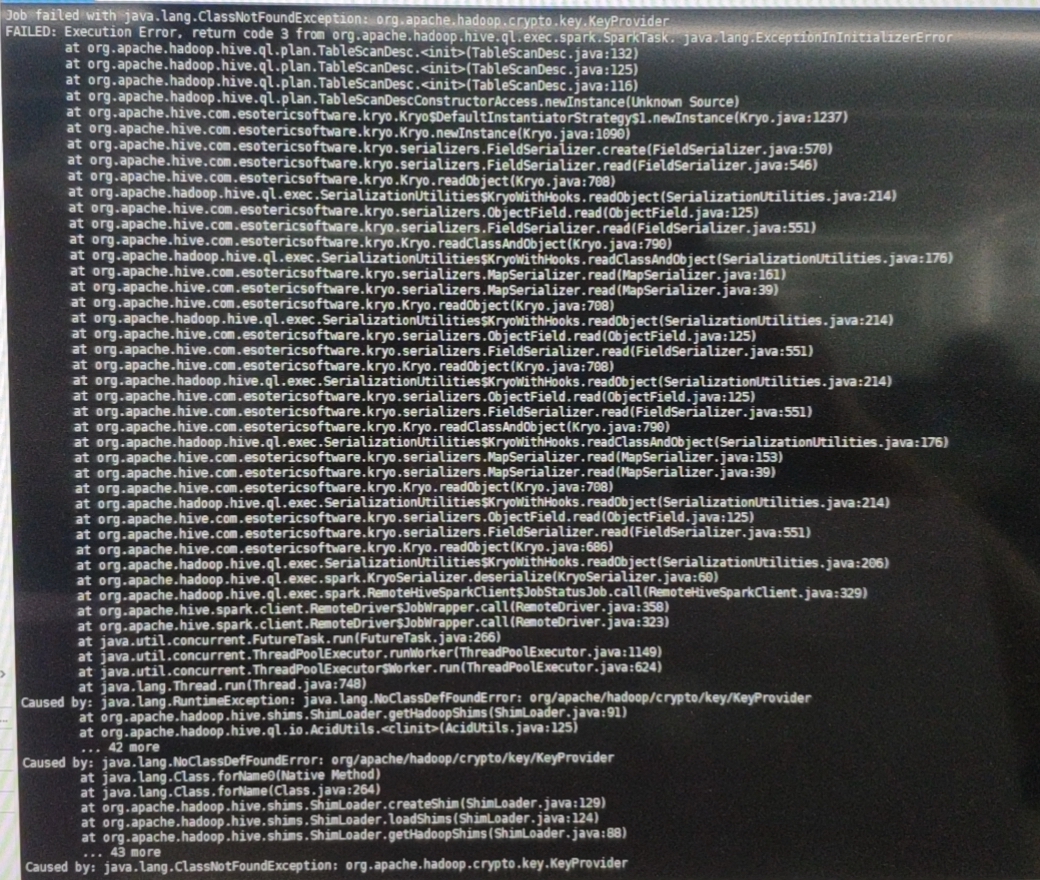

出现错误如下:

出现错误如下:hive failed with java.lang.classnotfoundexception:org.apache.hadoop.crypto.key.keyprovider

真的很急,拜托各位大佬,跪求解决!!!

我的spark版本是 spark-2.0.0 without-hive(在官网上下载的是匹配Hadoop2.4的)

我的hive版本 是 2.3.2

我的Hadoop版本是2.7.3

一开始以为版本差别不大应该没事呢,结果运行插入,建表没问题,如果查询就会出错

我现在的解决办法是把Hadoop-common-2.4.1放到hive/lib中,请问可以解决吗?

#Spark##Hadoop##Linux#

华为成长空间 479人发布

华为成长空间 479人发布 查看8道真题和解析

查看8道真题和解析