《卷积网络》卷积神经网络基础

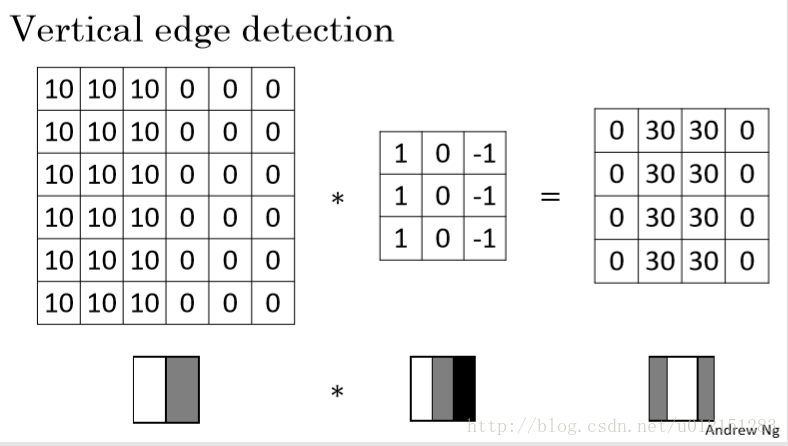

边缘检测例子

填充Padding

- Valid Padding

- Same Padding

保持卷积输出和输入维度相同,

卷积步长Stride

每次卷积核卷积操作后平移的维度。

当s=1,f=3,p=1或s=1,f=5,p=2时,卷积前后尺寸不变。

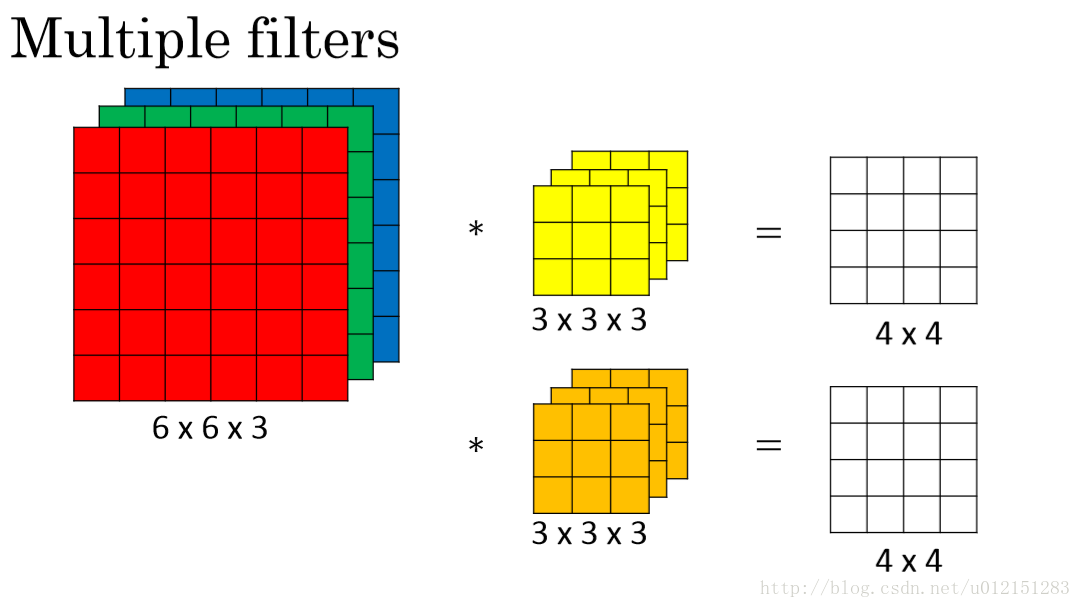

三维上的卷积

设输入维度 ,卷积核个数为 (即为输出通道数量),则卷积核维度 ,

共有 个卷积核,每个卷积核对上一层 个feature map进行卷积操作。

则输出维度 。

每个卷积核的参数量为

池化层Pooling Layer

池化一般分为MaxPooling和AveragePooling。池化层没有需要学习的参数。

与卷积层不同的是,池化操作是分别对每个切片单独进行计算的。而三维卷积是对所有切片一起计算的。

通常使用Valid Padding,即padding size =0。

设输入维度 ,池化层参数

则输出维度 。

使用卷积的原因

- 参数共享

通常一个特征检测子(如边缘检测)在图像某一部位有用也在其他部位生效。

同一个卷积核在图像的不同部位保持同一组参数。 - 稀疏连接

每一层的输出只依赖于前一层一小部分的输入。

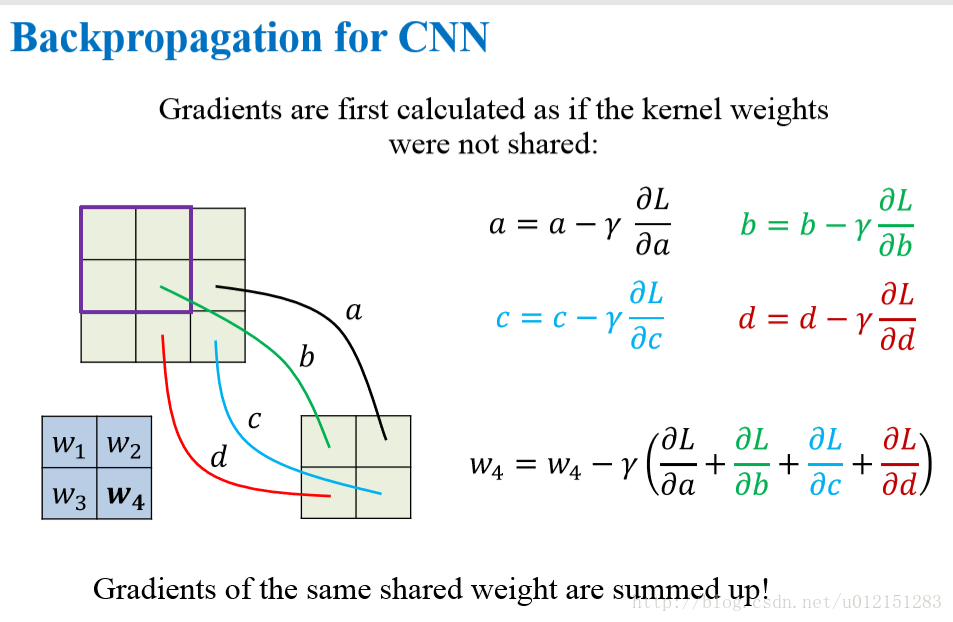

CNN的反向传播

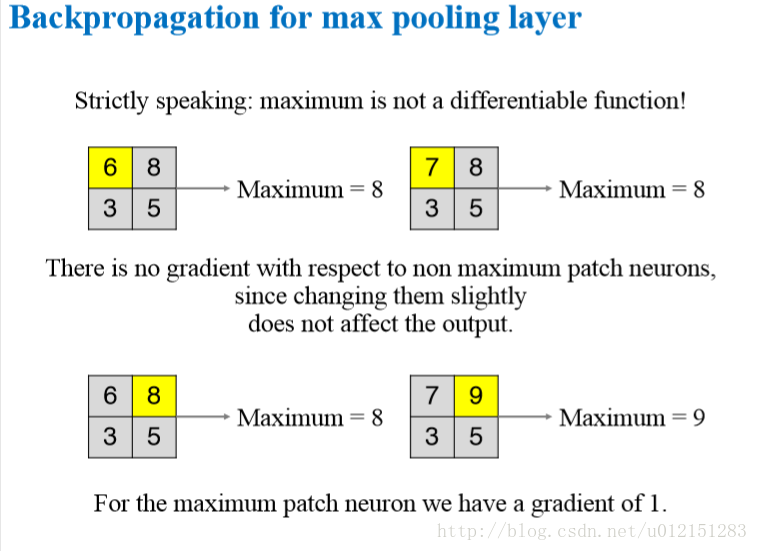

池化层的反向传播

CNN是全连接特殊形式,所以局部感受野之外的神经元为0,核参数在神经元之间共享。

参考资料

《深度学习》deeplearning.ai

抖音信息公司氛围 651人发布

抖音信息公司氛围 651人发布